Mit iOS 15, macOS Monterey und Co.: Apple kündigt neue Funktionen zum Schutz von Kindern an

Die früher am heutigen Tag durchgesickerten Informationen zum Thema Kindersicherheit sind nun offiziell. Auf einer neuen Webseite hat Apple dabei auch Informationen zu dem vorhin thematisierten Abgleich von Fotos auf dem iPhone, iPad und Mac mit Hashwerten zur Erkennung von Kindesmissbrauch bekanntgegeben. Dieser wird allerdings nur ein Teil einer größer angelegten Offensive zum Thema Kindersicherheit sein, die zunächst ausschließlich in den USA, später aber auch in anderen Regionen, mit iOS 15, iPadOS 15 und macOS Monterey umgesetzt wird.

Die früher am heutigen Tag durchgesickerten Informationen zum Thema Kindersicherheit sind nun offiziell. Auf einer neuen Webseite hat Apple dabei auch Informationen zu dem vorhin thematisierten Abgleich von Fotos auf dem iPhone, iPad und Mac mit Hashwerten zur Erkennung von Kindesmissbrauch bekanntgegeben. Dieser wird allerdings nur ein Teil einer größer angelegten Offensive zum Thema Kindersicherheit sein, die zunächst ausschließlich in den USA, später aber auch in anderen Regionen, mit iOS 15, iPadOS 15 und macOS Monterey umgesetzt wird.

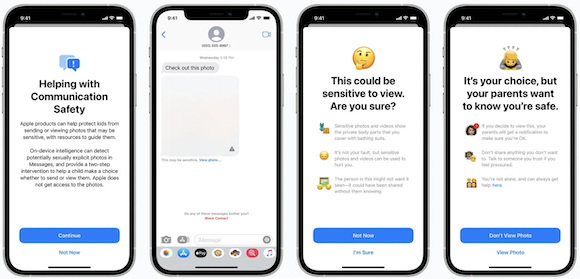

Mit einbezogen wird dabei auch iMessage, welches mit einer "Communication Safety" Funktion ausgestattet wird, die Kinder und ihre Eltern warnt, sobald sexuell anzügliche Fotos empfangen werden. Die Erkennung funktioniert auch in diesem Fall auf Basis von Maschinenlernen und findet komplett lokal auf dem Gerät statt. Sollte die Funktion anspringen, wird das empfangene Bild automatisch verschwommen dargestellt und eine entsprechende Meldung angezeigt. Sind die entsprechenden Schalter in der Familienfreigabe aktiviert, können sich auch Eltern über den Empfang eines solchen Bildes informieren lassen.

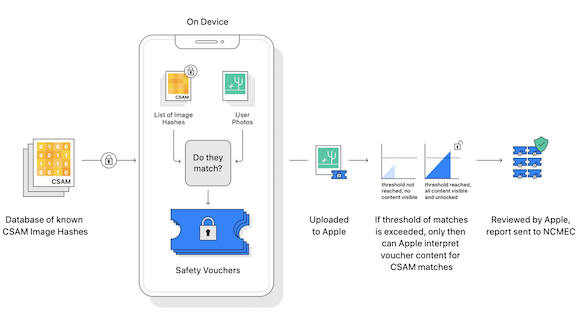

Ebenfalls mit iOS 15 und iPadOS 15 wird Apple die heute Nachmittag thematisierte automatische Erkennung von Bildern mit sogenanntem "Child Sexual Abuse Material" (CSAM), als Darstellungen von sexuellem Missbrauch von Kindern umsetzen. Wurden mehrere solcher Bilder in einem Account entdeckt, meldet Apple dies an das National Center for Missing and Exploited Children (NCMEC), eine Non-Profit -Organisation, die mit den Strafverfolgungsbehörden in den USA zusammenarbeitet. Dabei betont Apple, dass man auch bei der CSAM-Erkennung den Datenschutz in den Mittelpunkt stelle. Wie bereits berichtet, wird die Erkennung der Bilder auf Basis von Hashwerten aus der Datenbank der NCMEC und anderen Organisationen für den Schutz des Kindeswohls durchgeführt. Die dabei zum Einsatz kommende Technologie hört auf den Namen "NeuralHash" und vergleicht Hashwerte von Bildern auf denen Kindesmissbrauch zu sehen ist mit denen auf den Geräten. Hierzu schreibt das Unternehmen in einem neuen Whitepaper:

"The main purpose of the hash is to ensure that identical and visually similar images result in the same hash, while images that are different from one another result in different hashes,. For example, an image that has been slightly cropped, resized or converted from color to black and white is treated identical to its original, and has the same hash."

Die Bilderkennung wird wie gesagt auf dem Gerät selbst durchgeführt, bevor die Fotos auf iCloud Fotos hochgeladen werden. Wurde dabei eine Übereinstimmung festgestellt, wird das Bild entsprechend gekennzeichnet und anschließend hochgeladen. Wurde eine nicht näher benannte Anzahl von Übereinstimmungen bei einem Account festgestellt, werden diese manuell überprüft, der betroffene iCloud-Account deaktiviert und eine Meldung an das NCMEC getätigt. Zwar macht Apple zu dem Vorgang keine konkreten Angaben, versichert aber, dass man für einen "extremely high level of accuracy" sorgen und sogenannte "False-Positives" so weit es geht minimieren werde. Sämtliche Informationen hierzu lassen sich einer veröffentlichten technischen Dokumentation und der neuen Child Safety Webseite entnehmen.

Wie bereits weiter oben erwähnt, werden sämtliche Neuerungen in diesem Herbst mit iOS 15, iPadOS 15, watchOS 8 und macOS Monterey eingeführt. Dies gilt zunächst ausschließlich für die USA, soll jedoch schrittweise auch auf andere Regionen ausgeweitet werden.

Kommentare

Ansicht der Kommentare: Linear | Verschachtelt

Tom am :

Hatten damit Familien zerst\366rt.

Unschuldig

Tom am :

https://www.ifun.de/apple-prueft-icloud-fotos-auf-kindesmissbrauch-138935/

Was wird danach gescannt?

Das ist nur der erste Schritt - es geht um andere Dateien, die dann auch in weiterer Form gepr\374ft werden.

9/11 zieht f\374r Datenzugang nicht mehr.

Somit ist Zugriff zu allen Fotos auf dieCloud f\374r die Beh\366rden gegeben.

Im Zuge einer Rasterfahnung kann man dann noch immer sagen - sorry false positive.

WHC am :

RR703 am :

Tom am :